大手企業が生成AI導入でAWS採用のワケ クラウドのパイオニアが用意する“3つのレイヤー”とは

本記事は、アマゾン ウェブ サービス ジャパン合同会社の依頼を受けて、同社の広告として掲載しています。

生成AIが世の中に衝撃を与えてからすでに1年以上が過ぎた。当初は様子見、あるいは水面下で検討や開発を進めつつ公表はしていなかったような企業も、2024年には本格的な動きを見せそうだ。

もちろん、すでに導入を公表している企業もある。海外では米ファイザー、米デルタ航空、独BMW、日本では竹中工務店などがその一例だ。ファイザーは創薬における研究開発や製造、マーケティングに、デルタ航空は旅行者向けのチャットbotに、BMWは自動車ユーザーの体験向上に、竹中工務店は意思決定支援と生産効率向上に、それぞれ生成AIを活用している。

これらの名だたる企業に共通していることが一つある。生成AIとして米Amazon Web Services(以下、AWS)のソリューションを採用していることだ。

さまざまな生成AIベンダーがいる中、ユーザー企業が生成AI活用の基盤としてAWSを採用する理由は何なのか。この記事では、AWSの生成AIの強みについて解説したい。

生成AIの“岩盤”を中心とする3層構造

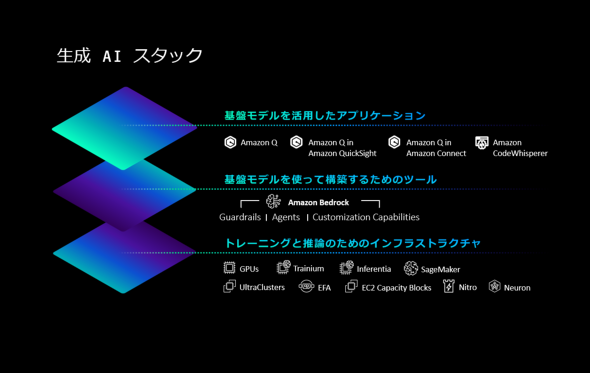

AWSの年次イベント「AWS re:Invent 2023」(以下、re:Invent)の基調講演に登壇したアダム・セリプスキーCEOが強調していたことの一つが「3つのレイヤーを持っており、どの段階でも関われるという強み」だ。3つのレイヤーとは「インフラ層」「ツール層」「アプリケーション層」を指す。

これらの生成AIレイヤーがあることにより、ユーザーが自社の目的に適した生成AIソリューションを活用できる。

「AWSの他のサービス同様、常にお客さまの長期的な活用を視野に、業務に求められる精度、コスト、スピード(回答速度)を兼ね備えたエンタープライズグレードのソリューションをご活用いただけるのがAWSの生成AIの強みです」とアマゾン ウェブ サービス ジャパンの黒川亮氏(AI/ML事業本部 プリンシパル事業開発マネージャー)は説明する。

黒川亮氏 2022年よりAWSにてAI/ML事業部プリンシパル事業開発マネージャーとして生成AI、責任あるAIを担当。現職以前は外資IT業界にてNVIDIA GPU搭載ハードウェア/IaaS事業、Watsonを含むData and AIソフトウェア/SaaS事業を牽引。27年間、3500名以上のお客さま、パートナーさまの業務に定着する日本発の世界初AI事例を創出していくため、各国専門家と奔走している。

黒川亮氏 2022年よりAWSにてAI/ML事業部プリンシパル事業開発マネージャーとして生成AI、責任あるAIを担当。現職以前は外資IT業界にてNVIDIA GPU搭載ハードウェア/IaaS事業、Watsonを含むData and AIソフトウェア/SaaS事業を牽引。27年間、3500名以上のお客さま、パートナーさまの業務に定着する日本発の世界初AI事例を創出していくため、各国専門家と奔走している。生成AIレイヤーの中でも、2017年から統合モデル開発環境として数百のモデルを生み出した実績のある「Amazon SageMaker」は基盤モデル開発企業から高い評価を受けている。一般企業には、ツール層で提供しているAmazon Bedrock(Bedrockは「岩盤」の意)が中心的な役割を果たしており、導入事例も多い。

まずはAmazon Bedrockでできることを詳しく見ていこう。

ツール層

選べる多彩な基盤モデル 数クリックでカスタマイズ

Amazon Bedrockの特長としてまず挙げられるのが、多くの基盤モデル(FM)の中から自社に適したものを選択できることだ。

FMは、言語、画像、音声、表など多様かつ大量のデータを学習した大規模な機械学習モデルのこと。これにファインチューニングを加えるだけで、イチから訓練し直さずともさまざまなタスクに対応できるようになる。なおOpenAIの「ChatGPT」やGoogleの「BERT」などのLLM(大規模言語モデル)はFMに包含される概念で、自然言語処理に特化したものだ。

AWSは自社開発のFMとして「Amazon Titan」シリーズを持っているが、あくまでユーザーにとっての選択肢を増やし、品揃えを充実させる意図で提供している。

Amazon Bedrockでは、Amazon Titanの他に英Stability AIの画像生成AI「Stable Diffusion XL」や仏 Mistral AI、日本語をはじめ多言語に堪能で文庫本1冊分のデータ(コンテクスト・トークン)を処理できる米Anthropicの「Claude」シリーズ、多言語展開やエンベディングに優れたカナダ・Cohereの「Cohere Command & Embed」などが同一UIで使用できる。

「FMは、業務との組み合わせにより強みが変わります。例えば日本語と英語が混ざるFAQシステムの場合は、正確な回答の精度が言語レベルによって改善する可能性があります。モデルを手軽に切り替えられることは、ユーザーの検索体験に大きく貢献します」(黒川氏)

FMのラインアップをそろえるだけでなく、それぞれのカスタマイズにも対応する。ラベル付けした追加データによるファインチューニング、データベースを参照して回答のための知識を得る検索拡張生成(RAG)、大量のラベルなしデータを使用する継続的事前トレーニング──といった3つのカスタマイズ方法で、FMの回答精度を上げたり、企業が抱える業務固有の新たな知識をFMに覚えさせたりできる。

カスタマイズのハードルを下げるべく、「Agents for Amazon Bedrock」という機能も用意。データベースとの接続や、カスタマイズのための指示を数クリックで自動構築できるようになる代物だ。

「既存の技術でも十分な業務に生成AIの利用を促しても定着せず、費用対効果が得られません。反対に、AIによる責任ある回答が担保できない業法や社会的評価に直結する業務はリスクがあり適しません。うまく人間の判断・チェックを促す、ちょうど良いサイズの業務から経験を積む上で、Agentsが効果を発揮します」

“モデル単位で扱える” だからこそセキュリティを確保

生成AIの企業導入に当たって気を付けるべき大きなトピックは、企業データの安全性の確保だ。

社外向けにせよ社内向けにせよ、例えばチャットbotであればカスタマイズには企業独自の情報を学習させる必要があるが、この「カスタマイズのためにLLMに渡す企業データ」が外部に漏えいしないかという懸念がある。また、チャットbotなどのサービスへの入出力から情報が漏えいしないか、という観点もある。

こうしたセキュリティ上の懸念に対しても、“選べるFM”という特長が効いてくる。

まず純粋なデータ管理という点については、他のAWSのサービスと同様のセキュリティポリシーが適用されるのはもちろんだ。それに加え、FMをカスタマイズするとそのモデルは対象の企業専用の安全なコンテナに格納される。当然、他社からそのモデルを参照されることはない。モデル単位で取りそろえているからこその、カスタマイズの懸念に対するクリアな回答といえる。

またAWSは「責任あるAI」を実現するためにAmazon Bedrockに「Guardrails for Amazon Bedrock」という機能を搭載している。

「欧州や日本などで生成AIの本格利用に当たってルール整備が進んでいます。業法や倫理、社会通念に照らして、生成AIが運用されることは企業にとって生命線です。GuardRailsは問題のあるコンテンツや、ライセンスを必要とする業法上の運用や個社の規定を反映して、望まない応答を防ぐための“ガードレール”を設定できます」(黒川氏)

Guardrailsは、広く海外進出している企業、法改正の頻繁な業種、技術革新のスピードが早い団体に、時代や地域に合わせた運用を実現するためのものだ。

インフラ層

“スパコン級”の計算性能をオンデマンドで

インフラ層では、生成AIの実行基盤とも言える強力な計算基盤をアピールする。

AWSはクラウドベンダーとして初めてNVIDIAのGPUをクラウドで提供した企業でもあり、NVIDIAとのつながりは深い。NVIDIAのフラグシップGPU「H100」を利用できる「P5 インスタンス」は1つのインスタンスとしての提供にとどまらず、クラスタとしてまとめて利用することも可能。最大2万台のGPUを束ね、スーパーコンピュータにも相当する最大20エクサFLOPSの計算能力を顧客に提供可能だ。

H100以外にも、AWSは自社開発のアクセラレーターチップ「AWS Trainium2」を用意。こちらはクラスタ化することで最大65エクサFLOPSと、さらに高速な計算が可能になっている。

冒頭に述べた通り、FM開発企業からは、統合モデル開発環境であるAmazon SageMakerが高い評価を受けている。実際、情報が公開されている中では最大級である1800億パラメータを持つLLM「Falcon 180B」(UAEのTIIが開発)は、3000台のGPUとAmazon S3に保存した数ペタバイトのデータを使い、Amazon SageMaker上でトレーニングしたものだ。

つまり、Amazon Bedrockでは「LLMを使う企業」に向けて有用なツール群を提供する一方で、このインフラ層では「LLMを開発する企業」に対して優れた計算資源や支援システムを提供できるということだ。

アプリケーション層

コーディングを提案する「Amazon CodeWhisperer」

AWSの生成AIアプリケーションといえば、まず思い浮かぶのがコーディングを支援する「Amazon CodeWhisperer」だ。コーディング支援の生成AIはすでに各社から出そろっているが、Amazon CodeWhispererは個人開発者なら無料で利用できることもあり、特に試しやすいといえる。

ただ、Amazon CodeWhispererを含む「登録するだけで使えるコーディング支援ツール」は一般的なコーディングタスクについては良い回答を示すものの、各社のコーディングルールや文化に最適化されたものではない。これはLLMの課題と同じだ。

これに対してAWSでは、Amazon CodeWhispererのカスタマイズ機能を2023年10月からプレビューとして提供している。企業内部のコードを学習することで、その企業に合わせたコードやAPIユースを提示できるようになる。

英BTグループでは、4カ月で10万行以上のコードをCode Whispererで生成した事例がある。同社は現在このソリューションを1200人のエンジニアに広げている。

ビジネスの随所に入り込む「Amazon Q」

re:Invent 2023で発表されたプロダクトの中でも最も注目を浴びたのが、この「Amazon Q」だろう。

ビジネスにおける生成AIアシスタントとして、幅広くユーザーの業務を支援する。セキュリティとプライバシーを確保した上で、企業内部の情報などに関する質問をチャットで回答してくれるほか、ビジネス文書の作成や要約、データ分析、コーディング支援など文字通り業務の「アシスタント」になってくれる。

また、Amazon QはAWSの専門家だ。AWSの各プロダクトについて分からないことを聞くだけで、ほぼ最善の答えをくれる。「ユーザーはAWS基盤に詳しいエンジニアが一人ずつ配備されているように感じるはず」と黒川氏も太鼓判を押す。さらに、回答するだけでなく具体的なアクションを起こすこともできる。

例えば「コードを変換して」とAmazon Qに依頼するだけでアプリケーションのバージョンアップが可能だ。Amazon内部でもこれを試したところ、1000個のアプリケーションをわずか2日間でJava 8からJava 17にアップグレードできた。

他にも、BIツールの「Amazon QuickSight」とも連携できる。Qに依頼するだけで、ダッシュボードやレポートの作成時間を短縮できるほか、ビジュアルを繰り返し洗練させていくこともできる。

ここまで見てきたように、AWSが用意する3つのレイヤーはそれぞれ「生成AIをカスタマイズして使う企業」「生成AIを開発する企業」「生成AIでできたサービスを使う企業」と企業ごとのニーズに合わせたものといえる。

各レイヤーでAWSならではの強みがあり、何よりすでにクラウド基盤としてAWSは幅広く使われている。

「パートナー企業の皆さんが長年ユーザー環境で培ってこられたAWS環境で、生成AIを取り入れる縁の下の力持ちになりたいと考えています。日本でもAWSの事例が2023年5月から出ています。英語のFMが先行しましたが、マルチモーダル、エンベディングが本格化する2024年、日本が生成AI活用をリードする最初の年になるよう、私達も尽力します」(黒川氏)

これから生成AIのビジネス活用を進めていきたい企業でも、すでに生成AIを使っていてさらに活用を推進したい企業でも、業務で生成AIを活用したい企業は業種や規模を問わずぜひ一度AWSに相談してほしい。

「AWS Security and Risk Management Forum 〜レジリエントな未来:生成AIなどの最新技術を活用したセキュリティ・リスクマネージメント〜」のご案内(2024年3月19日開催)

本イベントでは、生成 AI の活用やクラウドの活用の最新動向および生成 AI の押さえるべきポイント、AWS 内の取り組みについて解説します。また、有識者や外部ゲストを迎え、クラウドにおけるセキュリティ、リスクマネジメントに焦点を当てた各種対策を具体的に解説します。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

提供:アマゾン ウェブ サービス ジャパン合同会社

アイティメディア営業企画/制作:ITmedia AI+編集部/掲載内容有効期限:2024年3月29日